OpenAI 的 CLIP 有何亮点? - 知乎

简单的说,CLIP 无需利用 ImageNet 的数据和标签进行训练,就可以达到 ResNet50 在 ImageNet数据集上有监督训练的结果,所以叫做 Zero-shot。 CLIP(contrastive language-image pre-training)主要 …

CLIP 模型简介 - 知乎

CLIP (Contrastive Language-Image Pre-Training) 模型 是 OpenAI 在 2021 年初发布的用于 匹配图像和文本 的 预训练 神经网络模型,是近年来多模态研究领域的经典之作。该模型直接使用 大量的互联 …

如何评价OpenAI最新的工作CLIP:连接文本和图像,zero shot效果堪 …

CLIP这种方法的上限如何,query的数量和质量至关重要。 如果图像文本对仅仅通过搜索的方式在互联网上获取,感觉文本不太可能复杂,这个会限制CLIP的上限。 如果能找到一种获取大量图像文本对, …

为什么Clip可以用于zero shot分类? - 知乎

在CLIP的实验过程中,它从没有用ImageNet这个经典分类数据集上的数据做训练,但是在测试中,它却能达到和用了ImageNet做训练集的ResNet架构模型比肩的效果。 在我个人看来,CLIP解决缺点2的 …

视觉语言模型中的CLIP及同类的方法,都有哪些优势和局限?

与 CLIP 相比,DeGLA 展示了 8.8% 的平均性能提升,表明我们的方法通过局部和全局对齐策略更有效地利用了困难负样本。 得益于本研究生成的多样化负样本以及采用基于图像和文本的局部对比学 …

CLIP的可解释性有哪些问题,及怎么应用到各种open-vocabulary任务 …

CLIP的可解释性问题 二.为什么有这些问题 1.对于相反结果,原因在于self-attention。 具体来说用原来的query和key的参数出来的特征算self-attention,最相似的token并不是本身或者相同语义区域,而是 …

开放式耳夹耳机买前请注意!漫步者Comfo Clip实际表现如何?

咱把它挂起来 这是漫步者旗下新设计的耳夹式耳机,目前同佩戴方式的只有LolliClip,那是一款定位更高传感器更多(当然更贵)的产品,我手头的这款Comfo Clip耳机就亲民多了,300多的价格,挂在耳 …

多模态大模型是否一定要用CLIP作为Vision encoder? - 知乎

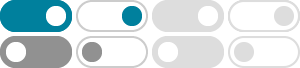

Jun 28, 2025 · CLIP 双塔架构 比如 BLIP 就是采用了VIT架构的vision encoder,但是到了BLIP2的时候,vision encoder也切换到了CLIP为基础的vision encoder。 第二个问题,“ 是否一定要基于VIT的架构 …

有哪些最新的针对CLIP跨模态图文检索的改改进方案啊?最好是不用做 …

Alpha-CLIP不仅保留了CLIP的视觉识别能力,而且能够精确控制图像内容的重点。 它在各种任务中都表现出了有效性,包括但不限于开放世界识别、多模态大型语言模型和条件 2D/3D 生成。

为什么至今 (2024.2)还未出现基于Swin Transformer的CLIP预训练模型? …

CLIP 的效果其实和模型结构关系不大,关键在数据质量,至于大家所说的局部特征,全局特征之分,在数据驱动的情况下, 细粒度的特征 来自细粒度的文本监督 发布于 2024-04-01 04:31 鳄鱼家的帅气 …